- Le marché des moteurs en France

- Les bases

- Analyse sémantique

- Contenu

- Optimisation On Site

- Optimisation Off Site

- Analyse des résultats

- Apparaître dans les résultats alternatifs

- Les outils SEO

- Les erreurs fréquentes

- Optimisation pour Bing

- Mauvaises pratiques et pénalités

- Aide extérieure

- Détente et lectures complémentaires

Le référencement naturel, c’est ce que vous avez pu croiser sous le joli nom de SEO (qui signifie Search Engine Optimisation ou « optimisation pour les moteurs de recherche » en Français). C’est le fait de tout mettre en œuvre pour qu’un site ressorte le mieux classé possible dans les résultats naturels des moteurs.

Le référencement est un travail qui s’effectue sur le long terme, qui est parfois fastidieux et très chronophage mais qui apportera à tout site un ROI (ou Retour sur Investissement) record, inatteignable par n’importe quel autre moyen d’acquisition de trafic.

Ainsi, il faudra probablement patienter plusieurs semaines voire plusieurs mois avant de voir vos efforts récompensés.

Par ailleurs, le SEO est entièrement gratuit. Gratuit dans le sens où vous ne pouvez absolument pas payer Google pour ressortir mieux classé. Toutefois, un budget est souvent appréciable : soit pour payer un consultant extérieur ou un freelance SEO ou pour vous économiser du temps et acquérir des liens faciles pour booster votre popularité.

On décompose souvent le SEO en 5 étapes :

- Bien choisir ses mots clés

- Optimiser le contenu de son site

- Optimiser techniquement son site

- Travailler la popularité du site

- L’analyse des résultats

Ce guide sur le référencement abordera les 5 étapes de manière ultra détaillée et pour chaque point clé, vous trouverez un lien pointant vers un article publié sur le blog détaillant le sujet.

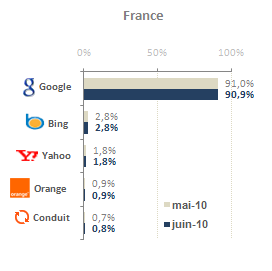

Le marché des moteurs en France

Avant de s’intéresser à comment optimiser un site, il est indispensable de comprendre pour qui on l’optimise. Et là, aucun mystère, en France comme en Europe, c’est Google qui domine très largement le secteur avec plus de 90% des parts de marché.

Ca veut dire deux choses : quand on optimise un site, on l’optimise pour Google et dès que Google effectuera un changement plus ou moins connu dans son algorithme, il faudra parfois réagir.

A coté, le dauphin de Google est Bing, le moteur de Microsoft qui partage grosso modo les principaux critères de Google, à quelques exceptions prêts. On abordera le sujet un peu plus loin, quand vous serez plus initié.

Le baromètre des moteurs de recherche de juin 2010 classé par pays est disponible ici (source AT Internet).

- Google est le moteur n°1 en France avec plus de 90% de parts de marché

- Il faut tenir compte des critères utilisés par Google en priorité

- Le dauphin n°1 de Google est le moteur de Microsoft, Bing. Les autres moteurs ne doivent pas être pris en compte car trop peu utilisés.

Les bases

Avant d’entrer dans les détails et dans la première étape, je vous conseille vivement de faire un petit détour vers les bases du référencement naturel, qui constituent une parfaite introduction pour expliquer à quiconque débutant dans le domaine du SEO les grandes lignes qu’il faut absolument comprendre.

Vous y trouverez une mini description des principales étapes qui constituent le référencement naturel, ainsi que les réponses aux questions que vous pouvez éventuellement vous posez, telles que « C’est long à mettre en place un référencement naturel ? » ou encore « Par où commencer ? ».

- C’est long à acquérir un positionnement?

- Quelles sont les 5 étapes du SEO?

Analyse sémantique

La première étape de tout travail SEO consiste à s’assurer que les mots clés sur lesquels on se positionne sont réellement recherchés. Par exemple, est-il plus intéressant de se positionner sur le terme web marketing ou sur le terme cyber marketing ?

Les termes auxquels on pense naturellement ne sont en effet pas toujours les plus recherchés et il convient donc de cibler des termes qui apportent un trafic ciblé, tout en étant un minimum recherchés.

Il faut toutefois nuancer cela puisque naturellement lorsque l’on créé un site web, on a pour objectif de capter le plus de trafic possible. N’oublions pas que l’objectif même d’un référencement réussi est de capter un trafic qualifié. Il faut ainsi éviter de :

- Se positionner sur des termes trop génériques (par exemple un site de critique littéraire qui se positionnerait sur le mot livre)

- Se positionner sur des requêtes trop concurrentielles (par exemple un petit site de mode qui chercherait à se positionner sur le terme « achat vêtement »)

- Cibler des mots clés qui n’ont rien à voir avec le sujet du site (par exemple un site sur la thématique des bébés qui se positionnerait sur le mot dessin animé)

Il faut constamment garder en tête qu’une première place sur des mots clés bien spécifiques est largement plus intéressante que de figurer en 3ème page d’un mot clé, même ultra recherché.

- Le principal est un outil officiel de Google: le générateur de mot clé

Imaginez deux sites : un site de passionnés de football et un site de paris en ligne. Tous deux pourraient souhaiter se positionner sur le mot clé « football » qui est recherché plus de 9 millions de fois par mois en France. Toutefois, 90% de ce trafic serait inutile car non ciblé. Maintenant, si le site de passionnés de football cible le mot clé « passion football » et le site de paris en ligne « parier football », chaque site pourrait acquérir jusqu’à 7000 visiteurs par mois, d’un trafic ultra ciblé et à priori intéressé.

Par ailleurs, il convient parfois de se positionner sur des termes annexes : un site eCommerce par exemple, vend des produits qui répondent à un besoin. Il est parfois plus judicieux de se positionner sur le besoin que sur le produit en lui-même (par exemple une agence de référencement qui vend des « solutions SEO » pourrait cibler des mots comme « visibilité sites internet » ou encore « référencement »).

Par la suite, la concurrence est un critère important à prendre en compte. Ainsi, pour chaque page de votre site, il est primordial de vous assurer que les mots clés que vous souhaitez cibler sont à votre portée, c’est-à-dire que la concurrence n’est pas trop rude.

Cela dépend de plusieurs critères : de combien de temps disposez-vous ? De quelle marge de manœuvre disposez-vous, etc.

Dans l’optique où vous n’avez aucune limite, vous pouvez avoir une estimation en regardant le nombre de pages indexées des sites qui ressortent dans les premières positions sur la requête en question. Jetez un coup d’œil sur leurs PageRanks, ainsi que sur le nombre de backlinks qu’ils possèdent (c’est-à-dire de liens pointant vers leur site, synonyme de popularité). Les pages qui ressortent sont elles des pages d’accueil ou des pages internes de site ?

En jetant un coup d’œil à tout cela, vous pouvez avoir une idée générale quant à la faisabilité d’un positionnement.

Attention à ne pas oublier les fondamentaux !

A vouloir trop optimisé, certains sites passent parfois à coté de leur cible principale : Danone par exemple, ne ressort pas sur le terme « produits laitiers », Pepito ne ressort pas sur le terme « gâteaux gouter » ou encore Kellog’s ne ressort pas sur le terme « céréales petit déjeuner ».

La véritable difficulté du travail sémantique consiste donc à chercher à capter le plus de trafic qualifié possible, sans s’éloigner de sa cible principale. Et bien qu’il n’est pas toujours évident de référencer un site tout en ayant en tête l’intérêt de l’internaute du début à la fin, c’est un passage primordial pour tout SEO réussi.

Enfin, sachez qu’en théorie, plus une requête sera tapée, plus il sera compliqué de bien ressortir dessus.

![]() Si vous souhaitez plus d’infos, deux articles illustrent bien le phénomène :

Si vous souhaitez plus d’infos, deux articles illustrent bien le phénomène :

- Il est conseillé de cibler 1 mot clé principal par page

- Il faut s’assurer que le mot clé choisi est bien recherché par les internautes

- Il faut prendre en compte la concurrence de chaque mot clé et affiner les mots clés en fonction de la profondeur des pages

Contenu

Après avoir bien choisi ses mots clés, il faut faire en sorte que le contenu leur corresponde au mieux. Autrement dit, que le contenu amène les réponses aux questions liées aux mots clés.

Et cela ne consiste pas à répéter un mot clé le plus de fois possible, c’est-à-dire à jouer sur la densité de mot clé. Un contenu optimisé pour les moteurs doit en théorie l’être également pour les visiteurs du site. Ainsi, plus le contenu sera riche, plus il aura de chance d’être jugé pertinent par Google.

C’est avant tout un contenu qui est constitué d’au moins 200-250 mots. Sans cela, Google a des chances de juger la page en question comme peu pertinente pour un mot clé, ou pire, spammy.

En théorie, plus le contenu est long, plus il est intéressant. Toutefois, un contenu trop long c’est mauvais pour les conversions : il faut donc trouver le juste milieu, qui se situe généralement autour des 500-1000 mots par page, voire beaucoup plus pour un blog ou une page spéciale.

Ensuite, le contenu se doit d’être organisé, c’est-à-dire avoir une structure logique: titre, sous-titres, paragraphes courts et concis, par exemple.

Le mot clé ne doit donc pas être répété tous les 10 mots, le texte doit être naturel et riche pour l’utilisateur. Il convient d’utiliser au maximum des synonymes qui permettront de crédibiliser la pertinence de la page vis-à-vis du mot clé.

Dans l’idéal, le mot clé sera régulièrement mis en valeur, par exemple en gras, en italique ou en couleur.

Enfin, il faudra intégrer un maximum de liens internes lorsque ceux-ci sont pertinents, sur une ancre optimisée directement au sein du contenu. Cela permettra d’indiquer aux moteurs la thématique de la page en question et constitue ainsi une excellente pratique en SEO (et cela est au passage très ergonomique).

Au final, le contenu détermine un champ lexical auquel doit correspondre le mot clé.

Chaque page doit en théorie cibler un mot clé principal. Toutefois, cela ne signifie pas que la page en question ne recevra pas d’autres visiteurs depuis Google arrivés grâce à d’autres termes.

Ainsi, la longue traîne c’est le fait d’attirer un maximum d’internautes sur des termes annexes et peu recherchés. Ils sont généralement constitués de 3 à 5 mots et sont trop peu recherchés pour qu’un site se positionne dessus. Toutefois l’addition de tous les termes longue traîne peut générer de nombreuses visites.

Plus un contenu sera complet et long, plus il aura de chances d’attirer des visites longue traîne. Dans la théorie, 80% du trafic naturel d’une page doit provenir du mot clé principal et 20% de la longue traîne. Dans la pratique, cela peut monter jusqu’à 50-50.

Il est également avéré qu’un contenu frais, c’est-à-dire récemment publié ou mis à jour permet parfois d’acquérir facilement de bons positionnements, du moins si le site est un minimum trusté par Google, c’est-à-dire un minimum âgé et que des contenus de qualité ont été publié par le passé sur le site. Un contenu frais peut donc s’avérer très puissant !

![]() Quelques articles sur le sujet :

Quelques articles sur le sujet :

- Un contenu optimisé SEO c’est quoi?

- La puissance d’un contenu frais

- Mettre à jour le contenu de son site grâce à Twitter

- La densité de mot clé pour les nuls

- Le contenu doit être placé au centre de toute stratégie SEO

- Un contenu de qualité dépasse généralement les 250 mots par page

- Le contenu doit paraître le plus naturel possible: par exemple en utilisant des synonymes du mot clé et en évitant de le répéter, assimilant la page à du spam

Optimisation On Site

L’optimisation On Site correspond à toutes les modifications plus ou moins techniques liées au SEO. C’est souvent à cela que beaucoup de personnes minimisent le SEO.

En réalité, le but premier d’une optimisation technique c’est de faciliter le travail des moteurs : c’est-à-dire faire en sorte de dérouler le tapis rouge à chaque visite de Google afin qu’il se sente plus à l’aise, favorisant ainsi le positionnement de vos pages.

Globalement, le point le plus important d’une optimisation dite technique, c’est de mettre en place une structure logique et ordonnée.

Pour cela, il est vivement conseillé d’intégrer le processus SEO avant la mise en ligne d’un site. Par exemple en créant une arborescence, c’est-à-dire mettre sur papier noir sur blanc la structure de votre site, son architecture. En effet, le meilleur moyen d’optimiser un site, c’est de penser à son SEO avant sa mise en ligne.

L’idée ici c’est de faire en sorte que l’organisation du contenu soit logique : par exemple mettre en place différents niveaux de pages, la page d’accueil, les pages catégories et en 3ème niveau, les pages produits, pour un site eCommerce. Il faut que la navigation soit la plus simple possible et qu’elle corresponde entièrement au schéma imaginé.

Par la suite, il faudra s’assurer que le code du site soit propre et sans superflu, par exemple en externalisant les différents styles dans des fichiers CSS et en respectant les normes mises en avant par la W3C (cf. les outils SEO) : cela permettra des temps de chargement réduits et mettra l’accent sur le contenu le plus important, la lecture du code étant facilitée.

- Optimisez le titre de vos pages en y intégrant le mot clé et en évitant les doublons

- Intégrez des balises ALT dans vos images, qui serviront d’alternatives textuelles

- Utilisez les balises Hn pour vos titres et sous-titres au sein des pages

- Intégrez des balises META comme par exemple la META description qui n’a pas d’intérêt direct en termes d’amélioration de positionnement mais qui vous laisse l’opportunité de choisir le texte à mettre en avant sous votre site dans Google

- Optimisation discutable : le fait d’avoir un mot clé dans son nom de domaine

Une fois le site en ligne, il conviendra de créer un fichier robots.txt. Le fichier robots.txt est la première chose que chercheront les moteurs lorsqu’ils visiteront un site. Ce fichier sert à indiquer aux moteurs ce que vous souhaitez qu’ils indexent et au contraire, ce que vous ne souhaitez pas voir indexer (par exemple les comptes utilisateurs ou des fichiers privés). C’est également là que vous indiquerez l’emplacement de votre fichier sitemap.xml.

Le sitemap.xml est un fichier créé spécialement pour les moteurs et qui recense toutes les pages de votre site. Ainsi, les moteurs en prendront connaissance et s’assureront de ne rien oublier lors de leurs visites. Vous pouvez également préciser dans le sitemap la fréquence à laquelle vous souhaitez que les moteurs vous rendent visite, mais vous n’êtes pas assuré qu’ils la respectent.

Enfin, le fait d’avoir des URLs propres peut également jouer en votre faveur. Pour mettre en place des URLs propres, il faut utiliser le fichier .htaccess, qui est un fichier placé à la racine de votre site.

Grâce à ce fichier, vous pouvez créer autant de redirection 301 que vous le souhaitez : les redirections 301 indiquent aux moteurs qu’une page a changé d’adresse et cela de manière permanente.

Ainsi, vous pouvez par exemple transformer des URLs incompréhensible à quelque chose de plus propre comme « http://www.votresite.com/categorie/votre-produit ».

Le duplicate content ou contenu dupliqué, c’est le fait qu’un contenu apparaisse à plusieurs endroits : cela peut être parce que vous avez du texte qui apparait sur chaque page ou encore des titres similaires pour vos pages.

C’est quelque chose de très mauvais car les moteur, Google en tête, pénalisent les pages qui ont du contenu dupliqué et c’est logique : chaque page doit répondre à un problème différent, si le contenu est similaire à une autre page alors ces pages seront jugées peu pertinentes et donc mal classées.

Le problème du contenu dupliqué, c’est que beaucoup de sites en souffrent sans le savoir : par exemple, un test simple consiste à accéder à un site avec les www puis en essayant d’y accéder sans les www. Si une des versions est redirigée vers la seconde, c’est une bonne chose. Si ce n’est pas le cas, alors peut-être que Google pourra considérer la version avec www comme un site différent de celle sans www.

Il y aura ainsi du contenu dupliqué puisque les pages seront systématiquement en double.

De la même manière, pour un site eCommerce, une page produit peut-être atteinte depuis plusieurs catégories : cela implique-t-il plusieurs URLs pour une même page ?

Pour éviter le contenu dupliqué, il est recommandé d’utiliser des redirections 301 via le fichier .htaccess ou la balise rel=’canonical’, prise en compte par Google, qui permet d’indiquer aux moteurs que seule l’URL précisée doit être retenue.

![]() Les articles publiés sur le blog correspondant à l’optimisation on site :

Les articles publiés sur le blog correspondant à l’optimisation on site :

- Comment identifier les problèmes SEO d’un site ?

- 10 points à regarder pour analyser le SEO d’un site

- 10 minutes pour optimiser son référencement naturel (les bases des bases)

- Faut-il utiliser un CMS pour créer son site ?

- Bien choisir son nom de domaine

- Une optimisation on site doit servir à aider le travail d’indexation des moteurs

- L’optimisation la plus importance consiste à mettre en place une architecture logique

- Mieux vaut éviter de modifier ce que vous ne maitrisez pas, comme par exemple toucher au fichier robots.txt ou au fichier .htaccess

Optimisation Off Site

Une fois le site bien organisé, les contenus optimisés et l’optimisation technique mise en place, il faut désormais s’assurer de la popularité du site.

La popularité du site est un critère extrêmement important aux yeux de Google. Autrement dit, Google prend bien note de ce que vous pensez de vous, mais donne beaucoup plus de crédibilité à ce que les autres pensent de vous.

Et pour deviner ce que les internautes pensent de vous, il regarde ce qui se dit sur vous sur la toile, c’est-à-dire qui effectue des liens vers votre site.

Et là, Google regarde plusieurs choses :

La quantité de lien : plus il y aura de liens, plus vous serez jugé populaires bien évidemment

La qualité des liens : sur Internet, c’est comme dans la vraie vie, il y a des personnes dont la parole vaut plus que d’autres. Par exemple, si Obama déclare sur son site web que votre site est super, Google lui fera entièrement confiance et nul doute que vous deviendrez extrêmement populaire aux yeux de Google. Maintenant, si un blogueur amateur effectue un lien sur le blog qu’il vient de mettre en ligne depuis 2 minutes, l’impacte sera infiniment plus petit.

De la même manière, si un blog ou un site est jugé particulièrement pertinent dans votre thématique, il est fort probable que Google lui fera particulièrement confiance et qu’un lien vers votre site sera extrêmement puissant.

La thématique du site : si vous avez un site sur le web marketing, un lien provenant du site d’un expert reconnu en web marketing aura 10 fois plus de valeur qu’un lien provenant du site de la boulangerie locale.

L’ancre des liens : l’ancre des liens a aussi une importance capitale. Il s’agit ici du texte utilisé pour effectuer le lien. Si le lien est effectué sur les mots « cliquez ici », alors il sera jugé peu pertinent. Maintenant, si le lien est effectué sur des mots optimisés, comme par exemple « guide référencement », alors Google notera que selon la personne qui effectue le lien, votre page est pertinente pour la requête en question.

Vous comprenez alors mieux pourquoi il est important de mettre en ligne des contenus de qualité, vous aurez plus de chance que des internautes l’apprécient et effectuent des liens, boostant votre popularité. On appelle cela le link bait, c’est-à-dire les liens qui se construisent naturellement, sans que vous ayez demandé quoique ce soit à quelqu’un.

Il est toutefois possible de booster soi-même sa popularité et de créer les liens indispensables à tout bon positionnement durable.

Il existe plusieurs moyens d’obtenir des liens, que ce soit en mettant du contenu en ligne sur des sites tierce, en commentant des blogs, en inscrivant son site sur des annuaires etc. Le fait de chercher à obtenir le plus de liens possible s’appelle le link building.

Un article publié sur le blog reprenait les méthodes principales pour obtenir des liens et ainsi travailler son link building.

De manière générale, il faut toujours garder en tête lorsque vous travaillez votre link building que ce travail doit paraître le plus naturel possible : en d’autres termes, Google doit penser que les internautes font eux-mêmes naturellement ces liens.

Et pour cela, il faut faire attention à :

- Ne pas acquérir trop de liens en un laps de temps trop court

- S’assurer d’augmenter le nombre de liens de manière régulière et logique

- Varier les ancres des liens que vous mettez en place

- Créer ces liens sur des sites un maximum proches de la thématique de son site

- Varier la popularité des sites et ne pas se focaliser que sur des sites très populaires

- Varier l’emplacement des liens

- Chercher à obtenir des liens de sites âgés et donc trustés mais également plus récents

Un autre élément à prendre en compte concerne l’attribut no follow. Implanté par Google quelques années auparavant, les liens no follow ont la particularité de ne pas être suivis par les moteurs, limitant ainsi grandement l’intérêt de ces liens.

Il faudra donc faire attention et privilégier si possible un maximum les liens dofollow, c’est-à-dire « normaux ».

![]() Pour aller plus loin dans les détails, voici les articles publiés sur le sujet sur le blog :

Pour aller plus loin dans les détails, voici les articles publiés sur le sujet sur le blog :

- Link building comme les pros, mode d’emploi

- Que faire de son budget SEO ?

- Pourquoi il est bon d’acquérir des liens No Follow

- Quid de la Google Dance ?

- Utiliser Google Alerts pour son site web

- L’optimisation off site doit servir à booster la popularité d’un site aux yeux des moteurs

- Il faut varier les sources des liens, ainsi que les ancres utilisées

- Un lien de qualité vaut une centaine de liens non qualifié. Un lien de qualité est un lien provenant d’un site sur la même thématique, au sein du contenu avec une ancre optimisée

Analyse des résultats

L’analyse des résultats est un passage obligatoire et primordial à toute campagne réussie. En effet, cela peut paraître simple à première vue et être réduit à la vérification d’un positionnement mais cela s’avère au final plus compliqué.

En effet, il ne suffit pas de simplement regarder les positions mais de regarder les mots clés qui apportent réellement un trafic qualifié.

Un trafic qualifié est un trafic qui transforme. En d’autres termes c’est un mot clé qui apporte des visiteurs qui achètent sur le site. Ainsi il est important de maîtriser un minimum l’analytique afin de construire des objectifs et d’intégrer la notion de transformation et de monétisation d’actions sur le site.

L’idée c’est que chaque action qu’effectuera chaque visiteur sur votre site vaut un certain montant : un formulaire rempli, une vente, devenir fan sur Facebook, etc.

En attribuant une valeur (parfois théorique, par exemple dans le cadre d’une souscription à une newsletter), vous pouvez constater les mots clés qui vous rapportent réellement de l’argent.

Ainsi, si vous être positionné 1er sur la requête que vous jugiez principale et que cette requête vous rapporte certes des visiteurs mais aucune vente alors qu’une requête annexe est très pertinente et vous rapporte beaucoup, vous saurez alors que vous avez concentré vos efforts sur le mauvais mot clé.

![]() Quelques articles sur le sujet paru sur le blog :

Quelques articles sur le sujet paru sur le blog :

- Comment mesurer le succès de votre SEO ?

- 20 métriques pour mesurer la performance de votre site

- Où s’arrête le SEO ?

- Les bases du web analytique

- Le web analytique pour les nuls

- Le web analytique est une étape incontournable du SEO

- Un travail de SEO réussi apportera non pas un trafic de masse mais un trafic qualifié

- Il faut intégrer la notion de retour sur investissement sur chaque mot clé, en donnant une valeur à chaque action effectuée par les visiteurs

Apparaître dans les résultats alternatifs

Depuis quelques années, Google inclue dans les résultats de ses pages de recherche, des résultats alternatifs. Ces résultats alternatifs peuvent prendre plusieurs formes : des résultats sous forme d’images, de résultats locaux, de vidéos, de définition, etc.

Actuellement, c’est plus de 77% des pages de recherche qui mettent en avant des résultats alternatifs. L’intérêt c’est que les résultats naturels sur certaines requêtes peuvent parfois être trop compétitifs : ces résultats alternatifs peuvent ainsi permettre de se positionner sur des requêtes autrement impossibles à cibler.

Les actions à mettre en place pour cela différent légèrement des actions habituelles bien que certaines d’entres elles correspondent.

Ainsi, la concurrence sur ces résultats alternatifs est souvent bien moins importante et ils peuvent générer un trafic parfois très important.

![]() Si cela vous intéresse, n’hésitez pas à lire les articles parus sur le sujet sur le blog et n’hésitez pas à repasser, le sujet étant régulièrement abordé :

Si cela vous intéresse, n’hésitez pas à lire les articles parus sur le sujet sur le blog et n’hésitez pas à repasser, le sujet étant régulièrement abordé :

- Apparaître dans Google Définition

- Le référencement « alternatif » (Google Images, Vidéo, PDF, etc.)

- 77% des pages de résultats Google incluent un résultat alternatif (images, vidéos, etc.)

- Les résultats alternatifs permettent parfois de se positionner sur des requêtes normalement trop compétitives et d’acquérir ainsi un trafic parfois important

- Les actions à mettre en place sont spécifiques pour chaque type de résultat alternatif

Les outils SEO

Un SEO bien réussi passe inexorablement par l’utilisation d’outils performants. Le problème c’est qu’il existe des centaines voire des milliers d’outils et il est facile de s’y perdre dans cette jungle.

Ainsi, je vous recommande la lecture de la section du blog consacré aux outils SEO, qui présentent les outils les plus indispensables.

Les erreurs fréquentes

L’erreur la plus fréquente et également la plus évidente : le manque de contenu ou un contenu peu riche. Il est vivement recommandé que le contenu soit au centre de toute stratégie SEO, du moins lorsque cela est possible.

Ainsi, Google considère parfois les contenus trop pauvres comme peu pertinents ou pire, comme du spam. La page en question sera ainsi fortement pénalisée et aura très peu de chance de ressortir sur la requête en question. Il est donc primordial de prendre le temps de rédiger un contenu riche qui répond à la problématique posée par la requête par laquelle est arrivé l’internaute.

Par ailleurs, le fait que les balises META ne jouent pas un rôle direct dans le positionnement d’un site fait qu’elles sont parfois trop négligées.

Pourtant, la balise META Description est très importante car elle incitera ou pas les internautes à cliquer sur le site. Une balise description optimisée peut permettre un taux de clic largement amélioré, apportant ainsi un plus grand nombre de trafic pour un même positionnement.

La balise META Robots est inutile si vous souhaitez que votre page soit indexée. Mieux vaut ne pas l’intégrer et s’assurer ainsi de ne pas effectuer d’erreurs.

Enfin, le contenu dupliqué est également une erreur qui peut vous pénaliser. Chaque page de votre site doit être unique et répondre à un problème précis, et unique. Or, si deux pages ont le même contenu, cela signifie qu’elles ne sont pas pertinentes (aux yeux de Google) pour répondre à deux problèmes différents : au final, les deux pages seront pénalisées et auront une grande chance de ne pas bien ressortir dans les pages de résultats.

Ainsi, un contenu dupliqué peut se traduire par le fait d’avoir, bien évidemment un contenu identique, ou plus simplement des titres identiques. Egalement, parfois le contenu dupliqué est involontaire.

Par exemple, si l’on peut accéder à votre site via l’adresse « http://www.votresite.com » ainsi que par l’adresse « http://votresite.com », alors Google considérera parfois cela comme deux sites identiques, et donc à du contenu dupliqué.

Cela est facilement évitable en implémentant une redirection 301 de la version sans www vers la version avec www (ou inverse) dans le fichier .htaccess. Si vous souhaitez plus d’information sur le contenu dupliqué, le sujet a été abordé dans la partie « Optimisation On Site » de ce blog.

![]() Les articles sur le sujet paru sur le blog :

Les articles sur le sujet paru sur le blog :

- L’erreur la plus fréquente est le fait d’avoir trop peu de contenu ou un contenu peu riche

- La balise META description, bien que non prise en compte par Google, peut générer de nombreux clics

- Le contenu dupliqué doit à tout prix être évité, sous peine d’être pénalisé par Google

Optimisation pour Bing

L’optimisation d’un site pour Bing comprend quelques différences mineures par rapport à une optimisation pour Google.

En effet, les principales différences sont :

- Les 1ers mots de la balise TITLE auront plus d’importance que les suivants

- Bing accorde plus d’importance aux mots clés présents dans les URLs

- Bing accorde plus d’importance aux mots en gras (via les balises strong ou b)

- Bing favorise les gros sites par rapport aux blogs et petits sites

De manière générale, il est vivement déconseillé de chercher à optimiser un site pour Bing : mieux vaut se focaliser sur Google qui apportera un trafic infiniment plus important, d’autant plus que 90% des règles semblent similaires au final. Attention toutefois à la vitesse d’indexation et d’évolution des classements de Bing qui peut s’avérer beaucoup plus lente que pour Google.

- Bing accorde beaucoup plus d’importance aux mots clés dans les URLs

- Les balises strong et b sont plus valorisés par Bing que par Google

- Les sites de grande taille sont à priori favorisé par rapport aux petits sites selon l’algorithme du moteur de Microsoft

Mauvaises pratiques et pénalités

La position officielle de Google vis-à-vis du SEO est un peu floue mais globalement, ils jugent que tout devrait être naturel et que personne ne devrait chercher à améliorer de manière volontaire son positionnement.

Ainsi, il y a des pratiques jugées comme frauduleuses par Google. Lorsqu’il est témoin d’une de ces mauvaises pratiques, Google a deux armes :

La sandbox : la première pénalité qu’utilise Google c’est le fait de placer un site dans sa sandbox. La sandbox est une sorte d’handicap qu’il inflige aux sites utilisant des mauvaises pratiques. Cela entraine une baisse soudaine de tous les positionnements du site, le tout durant plusieurs semaines ou mois, le temps que le site change de politique.

La blacklist : solution plus extrême et pourtant pas si rare que ça, Google peut blacklister un site, c’est-à-dire le désindexer en faisant en sorte qu’il n’apparaisse plus jamais dans ses résultats. Plusieurs gros sites en ont déjà fait les frais, comme par exemple le site de BMW il y a quelques années, bien que la sentence ait été annulée depuis.

A plus petite échelle, si un site est qualitatif mais qu’une de ses pages est jugée peu pertinente et spammy, le site ne subira aucune pénalité mais la page en question perdra alors son classement.

L’erreur la plus courante est tout simplement le fait de vouloir trop en faire. La suroptimisation a souvent les effets inverses de ceux escomptés.

Une suroptimisation peut se traduire par plusieurs choses, la plus fréquente étant un contenu lié à du spam avec une densité du mot clé atteignant des sommets.

Par ailleurs, il existe une pratique pour acquérir des liens qui consiste à les acheter à d’autres sites. Cette technique est radicalement prohibée par Google et il incite même les utilisateurs à dénoncer les sites proposant ou achetant des liens.

Enfin, de manière générale, Google n’apprécie particulièrement pas lorsqu’un site propose deux versions : une version pour les moteurs (par exemple un contenu suroptimisé) et une version pour les visiteurs (sauf rares exceptions). Ainsi, cette méthode appelé le cloaking est fortement réprimandé par Google et il est extrêmement dangereux de s’y intéresser.

Peut-être avez-vous déjà pu lire sur la toile ces fameuses expressions « White Hat » et « Black hat ». Ces expressions un peu caricaturales décrivent les référenceurs se limitant aux recommandations de Google, sans chercher à tricher d’aucune manière (les White Hat) et ceux un peu plus borderline qui jouent avec le feu et violent parfois ces recommandations de manière totalement volontaire afin d’acquérir de meilleurs positionnements (les Black Hat).

Il ne s’agit pas ici de choisir son camp mais de comprendre les risques liés au Black Hat : les pénalités citées ci-dessus.

De manière générale, Google est de plus en plus au courant de ces tactiques et affinent son robot pour qu’il les détecte de manière automatique et quasi systématique. Il est ainsi largement déconseillé, à moins de savoir ce que vous faites et d’en connaitre les risques, de vous aventurer sur de tels chemins.

![]() Un article expliquant le cloaking pour les nuls est paru sur le blog si cela vous intéresse :

Un article expliquant le cloaking pour les nuls est paru sur le blog si cela vous intéresse :

- Les sites violant les recommendations de Google risquent des pénalités

- La mauvaise pratique la plus courante est la suroptimisation

- Les techniques Black hat sont à éviter au maximum sous peine de voir votre site être lourdement pénalisé

Aide extérieure

Le SEO a deux problèmes majeurs si vous gérez un site : il est très chronophage et évolue très vite. Ainsi, optimiser un site est une chose. Le maintenir optimisé en est une autre.

Il est ainsi tout à fait possible de gérer vous-même votre SEO et en étant régulier dans votre veille et votre travail d’optimisation on et off site, nul doute que vous constaterez des résultats positifs.

Maintenant, lorsque l’on gère un site, on a souvent beaucoup d’autres préoccupations et le SEO peut s’avérer trop chronophage.

Il convient alors de déléguer soit une partie de son SEO, soit la totalité (voir plus simplement d’être conseillé) à une agence ou un prestataire extérieur.

Chacun jugera ainsi de la nécessité d’externaliser son SEO. Sachez que je propose au sein de Superbibi mes services de freelance SEO et que vous pouvez si vous le souhaitez demander un devis gratuit.

Détente et lectures complémentaires

Pour approndir un peu plus le sujet, je vous invite à repasser régulièrement sur le blog, à souscrire à son flux RSS ou à consulter les articles parus auparavant:

- 70 vérités que vous ignorez sur Google et le SEO

- Comment éviter de perdre son temps avec le SEO ?

- 5 fausses excuses pour ne pas faire de SEO

- Maîtriser la première page de Google sur son nom

- Toutes les acquisitions de Google en une image

- 25 idées pour ne plus perdre son temps

- 5 façons d’améliorer votre positionnement sans faire de SEO