Vous savez sûrement qu’il existe des méthodes plus ou moins appréciées de Google et des moteurs de recherche en général pour faire remonter un site dans les pages de recherche. On distingue d’ailleurs deux grands mouvements, le White Hat (les bonnes pratiques) et le Black Hat (les mauvaises pratiques). Une méthode Black Hat autrefois couramment utilisée s’appelle le cloaking.

Je vous propose aujourd’hui une piqûre de rappel pour certains et une explication pour d’autres sur cette méthode de référencement ainsi que quelques exemples pour illustrer tout cela.

Le cloaking expliqué à ma grand-mère

Chère grand-mère, lorsque tu visites un site il y a une partie visible et une partie invisible.

La partie visible, rien de plus simple, c’est par exemple l’adresse du site web dans le navigateur. Ça peut également être les balises META ou plus généralement le code source du site de manière générale (ma grand-mère est super high-tech n’est-ce pas ?).

Mais il existe également une partie invisible qui se traduit par exemple par du javascript. Le javascript c’est un langage de script utilisé principalement dans des pages HTML. Sans rentrer dans les détails, il permet d’intégrer une interaction avec les internautes notamment.

Et là où le bat blesse, c’est que les robots des moteurs de recherche ne savent lire que la partie visible d’un site. En résumé, les robots ne savent pas lire tout ce qui est invisible dans un code source, à savoir le javascript, le flash ou encore visionner les images par exemple.

Ainsi, la faille réside dans le fait de créer une page spécialement destinée aux robots des moteurs de recherche, optimisée pour le référencement naturel qui, pour caricaturer ne contient aucun contenu si ce n’est des mots clés. Le site proposera une version alternative design et très complète dans laquelle le contenu serait dissimulé dans du javascript ou dans un autre format illisible des robots sans se soucier d’une quelconque optimisation SEO pour les internautes.

En réalité il existe plusieurs manières de pratiquer le cloaking. Je ne vais pas toutes les détailler mais en citer une avant de passer à des exemples. Chaque propriétaire de site web peut identifier clairement ses visiteurs. Ainsi, si un robot vient visiter mon site, je saurai quel robot est venu et quand. Il existe des pratiques pour rediriger automatiquement ces robots en fonction de leurs noms ou de leurs IP vers une page optimisée pour le référencement naturel tandis que tous les autres internautes pourront accéder à la page « normale » du site.

Pour résumer le cloaking en une phrase : cela consiste à proposer deux versions différentes de son site : une pour les moteurs de recherche et une pour les visiteurs.

Court historique du cloaking

Le cloaking ça existe depuis de nombreuses années mais ça n’est que depuis 6 ans qu’il est réellement interdit et réprimander par les moteurs de recherche.

Pour se remettre dans le contexte, il y a 6 ans, le cloaking était régulièrement pratiqué et cela même de manière professionnelle, à savoir en agences de référencement par exemple.

L’exemple le plus connu est celui de BMW qui avait confié le référencement de son site à une célèbre web agency française (dont le nom commence par N pour ne pas la citer).

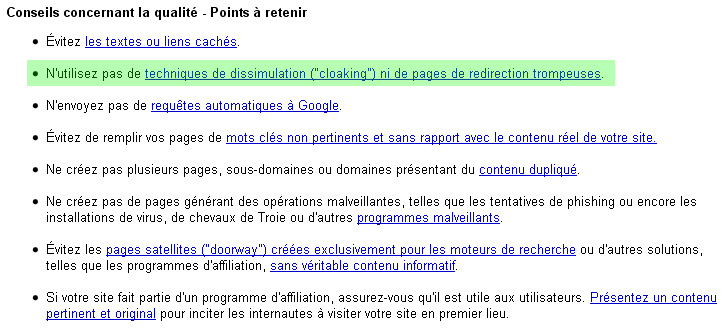

A l’époque, Google connaissait cette pratique et recommandait dans ses célèbres guidelines aux sites du monde entier d’éviter ce genre de pratiques malhonnêtes.

Guidelines accessibles ici.

Devant la crainte que de telles pratiques se banalisent, le moteur décida de changer de politique et fit de BMW un exemple en désindexant entièrement la marque allemande de toutes ses pages de recherche.

Rassurez-vous, BMW se porte très bien et après quelques négociations, Google a finalement réindexée les pages. Toutefois, depuis ce jour, la pratique du cloaking s’annonce réellement comme du Black Hat et il est vivement déconseillé de la pratiquer sous peine de subir des sanctions.

Le cloaking aujourd’hui

Vous allez me dire si c’est officiellement interdit pourquoi je vous en parle ? Et bien car c’est encore fréquemment utilisé et pas uniquement par des sites amateurs ou qui ont peu à perdre.

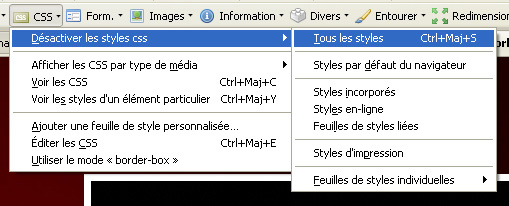

Là encore un exemple : il vous faut pour cela utiliser (ou télécharger) Firefox et avoir le module « Web developper » d’installé. Cela vous coûtera deux clics et vous apprécierez la qualité du plug-in (dont nous aurons besoin pour l’exemple).

Rendez-vous ensuite sur le site de la célèbre marque Cartier. Ça en jette n’est-ce pas ? Le site est très joli mais à première vue pas très optimisé pour le référencement naturel.

Pourtant si vous allez sur Google et que vous tapez « Cartier » le site ressort en premier alors qu’il y a fort à parier que c’est un mot très concurrentiel.

Où réside le secret ? Retournez sur le site de Cartier et désactivez les CSS grâce au module Web Developper.

Tiens donc, la barre de scroll s’est soudainement rallongée. Descendez un peu et observez ce qui apparaît sous le site. C’est du contenu dissimulé et c’est exactement ce qu’on appelle du cloaking. Le site contient clairement deux versions : une pour les moteurs qui lisent le texte caché par le CSS et une pour les visiteurs qui n’ont en théorie pas accès à ce texte.

Le texte ne contient évidemment que des mots clés et a pour but de maximiser le référencement du site.

Cela fait environ deux ans que le site tourne comme cela et ne subit aucune sanction. Notez toutefois que du jour au lendemain il pourrait subir les foudres de Google et être sujet à de lourdes sanctions.

A coté de cela, notamment dans les pays de l’est, le cloaking est poussée à une étape encore plus loin puisque Google n’est pas si dupe que ça et connaît les principales méthodes de cloaking. Il arrive d’ailleurs le plus souvent à les détecter en plus ou moins de temps. C’est une division « humaine » qui s’en occupe et non pas un robot qui serait optimisé pour détecter du cloaking.

Les webmasters des pays de l’est ont développé des techniques assez complexes qui consistent à intégrer du javascript dans du javascript, et cela sous plusieurs niveaux afin qu’il devienne titanesque de repérer ces méthodes de cloaking.

En résumé, le cloaking est clairement moins utilisé qu’autrefois mais reste toutefois d’actualité. Lorsque l’on s’intéresse au SEO, il est indispensable de connaître les techniques interdites sans quoi des erreurs seraient vite arrivées.

Je vous déconseille d’utiliser le cloaking au même titre que la plupart des techniques dites Black Hat puisque même si votre site remontera temporairement sur certaines requêtes, il y a fort à parier qu’un jour ou l’autre vous vous ferez prendre et votre site se fera sandboxer (blacklister par Google).

Vous apprécierez peut-être également:

- La liste ultime des erreurs bêtes en SEO

- Top 5 des erreurs SEO commises par les sites e-commerce

- 10 minutes pour optimiser son référencement naturel

- La densité de mot clé pour les nuls

- Comment mesurer le succès de votre SEO ?

Bien que le site Cartier montre en effet plus de contenu quand les feuilles de styles sont désactivées, je ne pense pas que cela puisse être comparé à du cloaking.

J’ajouterais même qu’une analyse par la team Google Spam verrait le site maintenu, pour la raison suivante :

– le site est basé sur du flash, donc contenu difficilement indexé par Google, malgré ce qu’ils disent. Les pages liées correspondent à des pages flash, l’information « cachée » n’est pas bourrée de mots clés, et suit de très près l’info contenu dans les pages flash.

Je pense donc que Google verrait cela comme une aide à l’accessibilité du site, plutôt que du cloaking pour obtenir de meilleur résultats.

Le fait que Cartier soit premier sur le mot clé « cartier » est du au nom de domaine, au millier de liens entrants pour Cartier.fr et aux dizaines de milliers de liens pour cartier.com. La soixantaine de mots « cachés » par le CSS n’y est surement pour pas grand chose.

Le cloaking de BMW était bourrage de mots clés sur une page en HTML, pas vraiment comparable à Cartier.

Dans la série des gros à qui tout est permis, on trouve aussi http://www.renault.com/fr/Pages/home.aspx

Même chose, il suffit de désactiver le JS et on découvre des liens qui ne sont pas dans la version « visiteur ». Rhoooo

@Léo: je suis tout à fait d’accord que le « cloaking » de Cartier n’est pas comparable à celui de BMW, il est d’ailleurs peu probable de voir du cloaking pur et dur renvoyant vers des pages sur-optimisées sans quoi cela serait trop facilement détectable.

Concernant le site de Cartier, je pense sincérement que le but premier de la marque n’est pas d’optimiser l’accessibilité du site mais ton analyse est très juste et étant donné que cela fait 2 ans que ça dure, je pense que Google ferme les yeux notamment pour les raisons que tu évoques.

@AxeNet: très juste, je ne savais pas pour le site de Renault !

A proprement parle, le cloaking n’est de toute facon pas decelable juste en desactivant la feuille de style ou les javascripts.

Le cloaking black hat est base sur la detection des robots des moteurs de recherches (via IP ou user agent en general) et la presentation a ces memes robots de pages specialement optimisees pour eux.

a priori la technique presentee dans ce post serait plus de la mise en palce de contenu invisible

@AxeNet Je ne vois que des liens présents dans la version visiteur de Renault !

@ Peyroles Ce n’était pas le cas il y a quelques semaines, ils en profitaient pour linker la page -http://www.renault.tv/fr_FR/passion/videos/143623/renault-changeons-de-vie-changeons-l-automobile-

Ils se font tellement pourrir la requête « changeons de vie changeons l’automobile » depuis que JAN et d’autres SEO se sont mis sur leur peau (moi compris), qu’il ne savent plus quoi trouver pour sortir du lot.

Ils ont sans doute pris peur depuis cette dénonciation publique : http://bvwg.actulab.net/49-ren.....u-noir.seo

Bon article 🙂

Juste une chose. Mis à part le fait que pour Cartier ce ne soit pas réellement du cloaking, se faire sandboxer n’est pas la meme chose que de se faire blacklister (cf. fin d’article) 🙄

Pour le site de Ranault ca ne me choque pas, c’est l’équivalent HTML de ce que l’on a en flash :p