Avec l’avènement toujours plus fort de la notion de silo dans le SEO moderne, on a vu une pratique relativement ancienne revenir au goût du jour : l’obfuscation de liens. Cette pratique qui consiste à masquer des liens à Google tout en les laissant à la disposition des utilisateurs a l’avantage de réconcilier sérieusement les spécialistes UX aux SEO. Regardons ensemble de quoi il s’agit ainsi que quelques exemples.

La notion de silo

La notion de silo n’est pas nouvelle : elle a même été (et est toujours) particulièrement mise à l’honneur par la stratégie de cocon sémantique, encore très répandue en France.

La notion de silo consiste ainsi à regrouper des pages par thématiques et notamment au niveau du maillage interne. Logique me direz-vous. Pourtant, cela va à l’encontre de certains éléments UX ancrés dans les pratiques courantes : méga-menu, navigation générique ou encore footers plus ou moins fournis.

Google traitant désormais les sites dans leur ensemble et non plus page par page, il récompense ceux qui évitent d’intégrer des liens vers la catégorie clé USB depuis la page parapluie.

Il estime ainsi que lorsque l’utilisateur effectue une requête sur son moteur, son besoin réel peut aller outre sa requête initiale et que plus un site est complet non pas que sur le mot clé mais aussi sur la thématique du mot clé de manière plus large, plus il sera à même de satisfaire les internautes. Google récompensera ainsi les sites complets, c’est-à-dire les silos.

L’obfuscation c’est quoi ?

Les débats, parfois houleux, entre SEO et UX faisaient ainsi rage à propos des méga menus par exemple : parfois (souvent) très utiles d’un point de vue UX, surtout en e-commerce, ils allaient totalement à l’encontre de cette notion de silo. Depuis la page « Ecran PC » je peux accéder à toutes les sous-catégories de ma rubrique « Litterie » : pas top pour compléter la requête de l’internaute…

Il n’était ainsi pas toujours évident d’expliquer qu’il fallait s’en passer pour des performances SEO idéales alors que nous apprécions tous, en tant qu’utilisateur, cette fonctionnalité.

Heureusement, l’obfuscation est revenue à la mode. Là où cette pratique était considérée bordeline, voire gray-ish (black ?) hat, elle est désormais exploitée par la majorité des grands acteurs du web français. De la même manière, là où l’obfuscation servait à l’exploitation optimisée des facettes, elle est désormais exploitée de manière bien plus large à tous les niveaux du site : menu, contenu et footer.

L’obfuscation donc, consiste à masquer une partie de son contenu (des liens souvent) à Google tout en les laissant présents sur la page. Pratique !

Alors, comment on fait ?

Il existe en réalité plusieurs méthodes d’intégration, la plupart du temps basées sur du JS.

Je charge une partie de mon site (mon méga menu par exemple) via un script JS : le code n’est donc plus présent côté serveur mais uniquement exécuté coté client. Ne me reste ensuite qu’à bloquer l’accès à Google à ce script, via une règle dans le robots.txt par exemple (ou via un blocage serveur).

Certains vont plus loin et réalisent du cloaking pour se protéger au maximum.

Au final, une partie de mon site est chargée par un script externe qui est très bien exécuté par tous les navigateurs modernes et donc par les utilisateurs mais que Google ne pourra jamais voir. Plutôt safe à première vue !

On peut pousser la pratique un peu plus loin et charger les éléments bloqués en asynchrone, au rollover par exemple : le script devient encore plus compliqué à détecter par Google qui n’aura probablement jamais la curiosité d’aller le consulter et qui considérera le non crawl du fichier comme relativement mineur à ses yeux.

Quelques exemples

Les sites à pratiquer l’obfuscation sont très nombreux en France.

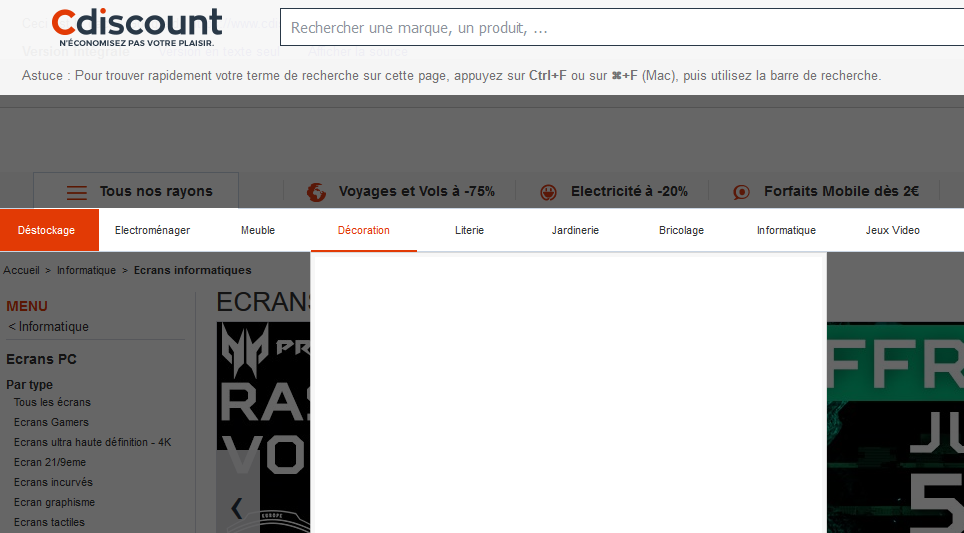

On peut par exemple citer Cdiscount qui masque une partie de son méga menu et son footer. Pour le tester, il vous suffit d’aller sur une page catégorie (celle de votre de choix).

Ici par exemple, je vais regarder la catégorie « Ecrans PC » :

En regardant le cache de cette URL, je remarque que l’ensemble des blocs du méga menu sont vides :

Pourtant, ils sont bien complétés lorsque je regarde la version normale, sur laquelle je navigue : ces blocs sont en réalité chargés par du JS qui est bloqué à Google.

De la même manière, le footer n’apparaîtra pas sur la version cache alors qu’il apparait très bien sur le site normal en tant qu’utilisateur.

C’est 100% bénéfique pour le site : l’utilisateur peut continuer d’utiliser le méga menu et accéder en quelques clics à l’ensemble des sous-catégories depuis partout et à côté, mes silos restent bien dessinés et je profite de l’apport sémantique de la navigation à 100%.

J’ai le beurre et l’argent du beurre.

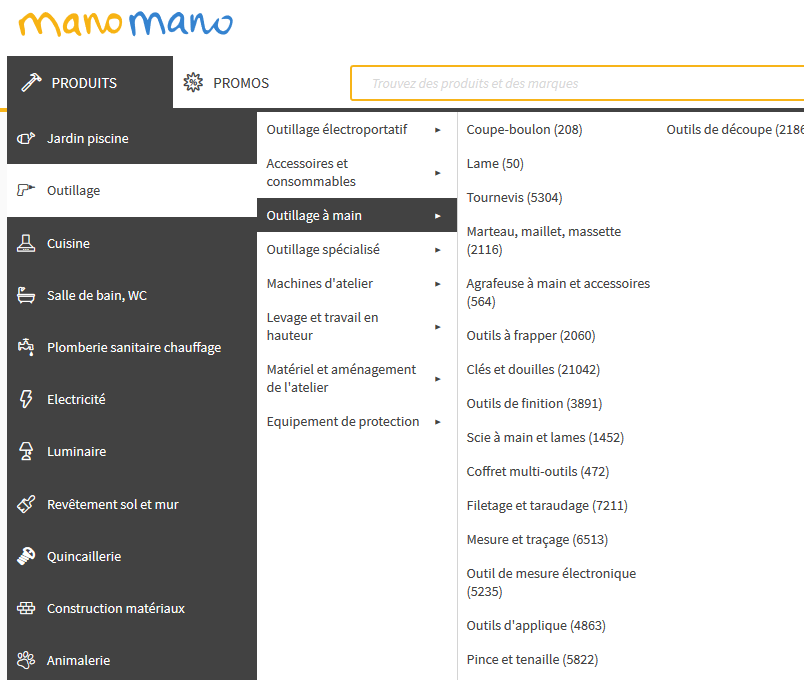

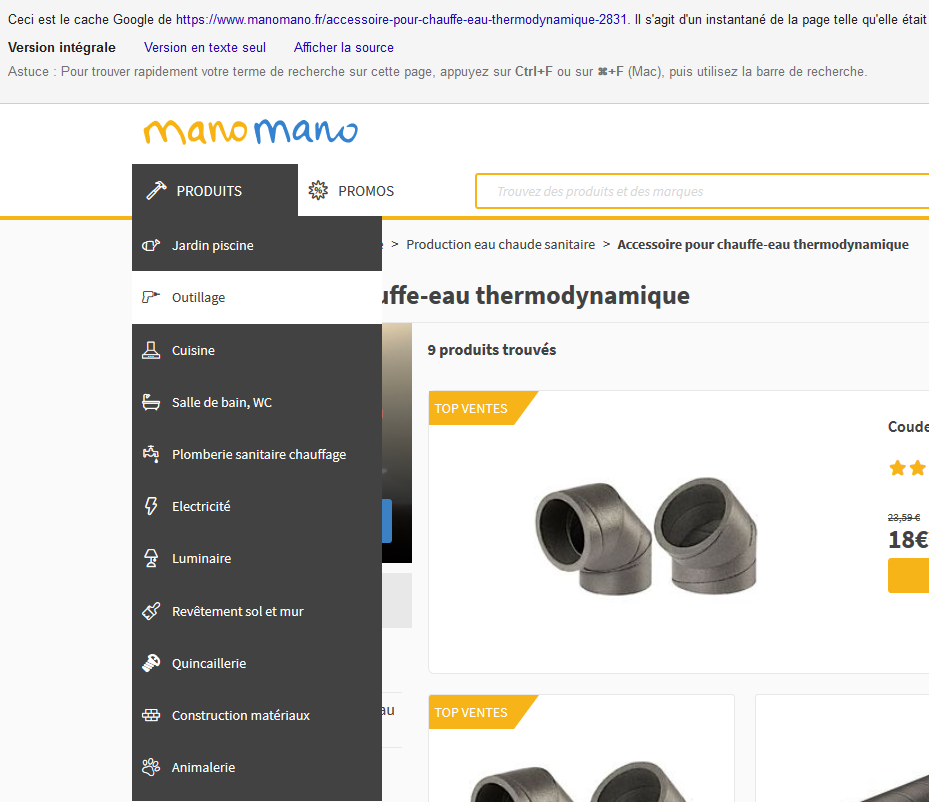

Si l’on regarde d’autres géants de l’e-commerce, par exemple ManoMano.fr, on retrouvera des pratiques similaires.

Depuis n’importe quelle page du site, je peux accéder au bloc « Produits » qui fait office de méga menu :

Maintenant, si je regarde la même page avec la version cache :

Plus rien ne s’ouvre : seuls les premiers niveaux sont visibles à Google, ce qui limite toute déperdition et m’assure des silos propres et dessinés.

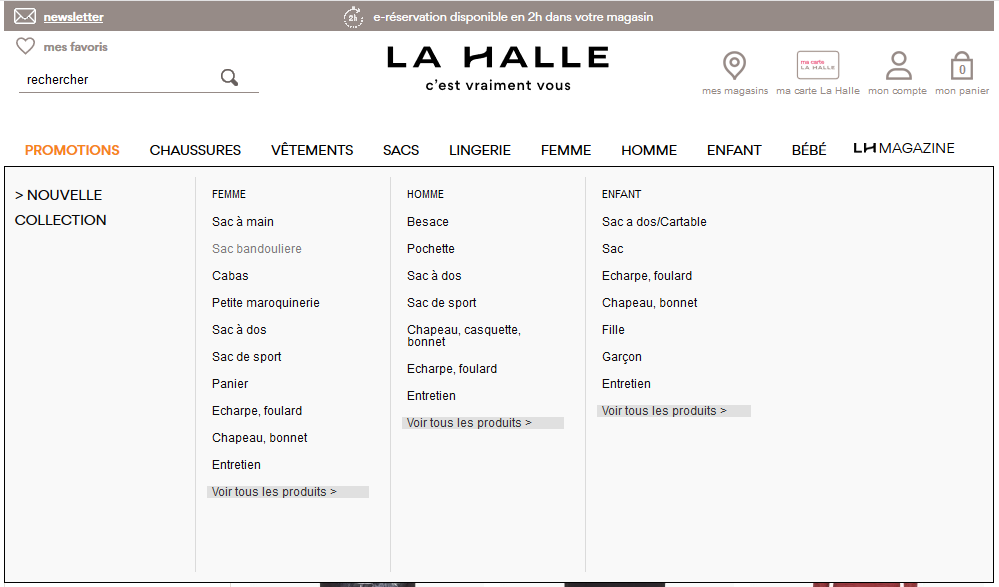

Un dernier exemple ? Regardons le site de La Halle. A l’instar de Cdiscount, si je navigue dans une catégorie au hasard, j’aurai toujours accès au méga menu en tant qu’utilisateur :

Maintenant, si je regarde la version cache : plus rien ne s’ouvre au passage de la souris sur les premiers niveaux. Le menu est obfusqué.

Petite précision : si vous souhaitez tester l’obfuscation de certains sites, ne la testez pas sur la page d’accueil. Misez plutôt sur des pages catégories : une navigation exhaustive n’est pas un problème sur une page d’accueil, c’est même recommandé. Souvent l’obfuscation commence ainsi au niveau des pages catégorie.

L’obfuscation est-elle pénalisable par Google ?

C’est une question qui pourra faire débat et qui se basera sur le niveau de paranoia que chacun peut avoir face au géant américain. La réalité veut que de nombreux grands acteurs l’utilisent de manière poussée, sans être pénalisés jusque-là. Ils profitent ainsi de gains SEO qui pourraient leur apporter un avantage concurrentiel non négligeable, dans la mesure où la concurrence se montrerait plus frileuse face à cette pratique.

Dans la théorie en tout cas, il paraît compliqué d’imaginer Google outrepasser le robots.txt pour tester un fichier JS relativement mineur à ses yeux. Reste à savoir l’impact des équipes « humaines » de Google, leur vision des choses et leur pouvoir réel. Au final, sans se lancer dans de la science-fiction, je pense qu’on peut affirmer que cette pratique est relativement sûre.

L’obfuscation est ainsi en plein boom et l’avènement du JS et de la notion de silo ne vont pas constituer des freins à son développement, bien au contraire. Finis les débats sur l’impact d’un méga menu et sur l’interprétation que peut en faire Google : plus besoin de lui laisser le choix et de subir son incompétence (théorique) sur le sujet. Il suffit tout simplement de miser sur l’obfuscation.

Vous apprécierez peut-être également:

- Le nombre de pages idéal en SEO

- SEO : Optimiser son contenu en 2015 (Silo, Knowledge Graph et TF-IDF)

- Peut-on réellement copier le SEO d’un site qui performe ?

- Mon CMS, c’est Twitter

- SEO : Préparer Noël en été pour réussir les fêtes de fin d’année

Attention à l’utilisation du cache, Google ne présente pas ce que Googlebot réussi réellement à crawler, comme confirmé par John Mueller à plusieurs reprises.

Très juste et après vérification il semble en effet que l’obfuscation soit au finale principalement limitée à l’usage de JS, parfois sans même supprimer les liens du HTML côté serveur. Les exemples de l’articles ne sont ainsi pas les mieux pour illustrer le propos, qui n’en reste pas moins d’actualité malgré tout.

Merci beaucoup pour cette remarque !

Pour les intéressés, le résumé du Hangout de John Mueller : https://www.deepcrawl.com/blog/news/google-webmaster-hangout-notes-june-26th-2018/